東京工業大学が大規模にGPUを搭載した初のスーパーコンピューター

TSUBAME1.2として実現、一気に10年後の性能へ

2008.12.11−東京工業大学は、実効性能で国内の第2位、世界では29位にランクされるスーパーコンピューターシステム「TSUBAME」を、このほど報道関係者に披露した。11月に世界で初めて本格的にGPU(グラフィックプロセッサー)を中心とした演算装置の増設を行い、「TSUBAME1.2」に強化したことを受けたもの。流体シミュレーションなどで100倍以上の高速化を達成した。責任者の松岡聡教授(学術国際情報センター研究基盤部門)は、「ムーアの法則に従うCPUの速度向上は10−15年で100倍だが、GPUを導入すればそれを1年で100倍にできる。いわば、10年後の性能をいま手にすることができる。しかも、同じ性能なら60台のラックが2台になり、消費電力は24分の1。今回のTSUBAME1.2は、スーパーコンピューティングのメインストリームがGPUアクセラレーションに変わる時代への、まさに第一歩を踏み出したものだといえる」と述べた。

◇ ◇ ◇

TSUBAMEは、2006年4月に実効性能38テラFLOPS(当時のアジア1位、世界7位)で誕生したスーパーコンピューターで、AMDのオプテロンプロセッサーを中心とした異機種混合型のクラスターシステム。このため、逐次増設を行うことで性能アップが可能であり、2007年には分子動力学シミュレーション用のアクセラレーターボード「ClearSpeed CSX600」を648枚(52.2テラFLOPS)追加するなどしてTSUBAME1.1に発展。そして今回、エヌビディアのGPUを搭載した「Tesla 10P」アクセラレーターを組み込んでTSUBAME1.2へと成長させた。

TSUBAMEは、2006年4月に実効性能38テラFLOPS(当時のアジア1位、世界7位)で誕生したスーパーコンピューターで、AMDのオプテロンプロセッサーを中心とした異機種混合型のクラスターシステム。このため、逐次増設を行うことで性能アップが可能であり、2007年には分子動力学シミュレーション用のアクセラレーターボード「ClearSpeed CSX600」を648枚(52.2テラFLOPS)追加するなどしてTSUBAME1.1に発展。そして今回、エヌビディアのGPUを搭載した「Tesla 10P」アクセラレーターを組み込んでTSUBAME1.2へと成長させた。

Tesla 10Pは、エヌビディアのGT200グラフィックチップをベースにHPC(ハイパフォーマンスコンピューティング)向けに製品化されたアクセラレーターで、ストリームプロセッサーを240個(CPUのコア数に相当する)搭載している。エヌビディアは、C言語でTeslaなどのGPUにプログラミングすることができる“CUDA”(Compute Unified Device Architecture)を提供しており、通常のCPUでの計算に比べて量子化学の二電子積分で130倍、分子動力学で137倍などのベンチマークを記録している。

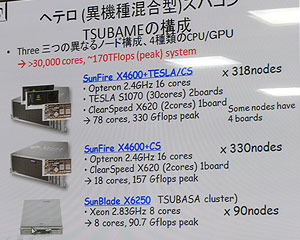

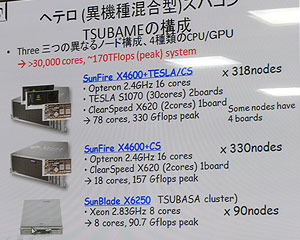

TSUBAME1.2では、Teslaを4個搭載した1Uサーバー形状のS1070を170台(Teslaが680個)装備している。これにより、現在のTSUBAME1.2の全体としては、オプテロンマシンのSunFire X4600にTeslaおよびClearSpeedを接続したノードが318、SunFire X4600にClearSpeedを装着したノードが330、ジーオンマシンのSunBlade X6250ノードが90−という構成になっており、3つの異なるノードと4種類のCPU/GPUが混在する異機種混合型のスーパーコンピューティングシステムとして運用されている。

東工大では、本格的なTesla導入に先立ち、マイクロソフトと共同研究のかたちでWindowsHPCサーバーとエヌビディアのGPU「GeForce8800GTS」128個を採用した実験用クラスターを構築。3次元たん白質ドッキング計算を実施した。32ノードの実験用クラスターで計算した結果、産業技術総合研究所が所有している4,096ノードのBlueGene/Lとほぼ同等の性能を発揮することが確認できたという。ただ、消費電力が小さいため、電力当たりの性能はBlueGene/Lの4倍となった。

松岡教授によると、GPUアクセラレーションは、高いピーク性能を生かした密結合問題と、高いメモリーバンド幅を生かした疎結合問題のどちらにも適しているという意味で、伝統的なベクトルマシンによく似たイメージで利用することができるのだという。消費電力の問題を考えると、CPUとGPUを組み合わせたヘテロジニアスな環境がこれからのスーパーコンピューターの主流になっていくとした。

松岡教授によると、GPUアクセラレーションは、高いピーク性能を生かした密結合問題と、高いメモリーバンド幅を生かした疎結合問題のどちらにも適しているという意味で、伝統的なベクトルマシンによく似たイメージで利用することができるのだという。消費電力の問題を考えると、CPUとGPUを組み合わせたヘテロジニアスな環境がこれからのスーパーコンピューターの主流になっていくとした。

ただ、CUDAによるプログラミング環境は便利だが、自動ベクトル化などのコンパイラー技術の開発がさらに求められるほか、デバッグのしにくさ、また多くのユーザーが共同利用するための環境の整備に課題があり、さらに研究を進めていく方針でもある。

東工大では、2010年春にさらにシステムを増強し、TSUBAME2.0を実現する計画。ペタFLOPS級の計算能力を達成するが、基本的な構成は今回のTSUBAME1.2を踏襲したものとなるようだ。

また、記者説明会では、青木尊之教授(学術国際情報センター)がいくつかのデモンストレーションを披露した。これらのデモは実際にTSUBAMEを利用してリアルタイムで行われたもので、GPUアクセラレーションの効果がはっきりと理解できる。青木教授は、GPUをシミュレーションの一部だけに使うことはあまり効果がないとした。CPUとの通信がボトルネックになるためで、「できるだけ全部の計算をGPUでした方が良い」と強調した。

●GPUアクセラレーションのデモ(その1)

●GPUアクセラレーションのデモ(その2)

TSUBAMEは、2006年4月に実効性能38テラFLOPS(当時のアジア1位、世界7位)で誕生したスーパーコンピューターで、AMDのオプテロンプロセッサーを中心とした異機種混合型のクラスターシステム。このため、逐次増設を行うことで性能アップが可能であり、2007年には分子動力学シミュレーション用のアクセラレーターボード「ClearSpeed CSX600」を648枚(52.2テラFLOPS)追加するなどしてTSUBAME1.1に発展。そして今回、エヌビディアのGPUを搭載した「Tesla 10P」アクセラレーターを組み込んでTSUBAME1.2へと成長させた。

TSUBAMEは、2006年4月に実効性能38テラFLOPS(当時のアジア1位、世界7位)で誕生したスーパーコンピューターで、AMDのオプテロンプロセッサーを中心とした異機種混合型のクラスターシステム。このため、逐次増設を行うことで性能アップが可能であり、2007年には分子動力学シミュレーション用のアクセラレーターボード「ClearSpeed CSX600」を648枚(52.2テラFLOPS)追加するなどしてTSUBAME1.1に発展。そして今回、エヌビディアのGPUを搭載した「Tesla 10P」アクセラレーターを組み込んでTSUBAME1.2へと成長させた。

松岡教授によると、GPUアクセラレーションは、高いピーク性能を生かした密結合問題と、高いメモリーバンド幅を生かした疎結合問題のどちらにも適しているという意味で、伝統的なベクトルマシンによく似たイメージで利用することができるのだという。消費電力の問題を考えると、CPUとGPUを組み合わせたヘテロジニアスな環境がこれからのスーパーコンピューターの主流になっていくとした。

松岡教授によると、GPUアクセラレーションは、高いピーク性能を生かした密結合問題と、高いメモリーバンド幅を生かした疎結合問題のどちらにも適しているという意味で、伝統的なベクトルマシンによく似たイメージで利用することができるのだという。消費電力の問題を考えると、CPUとGPUを組み合わせたヘテロジニアスな環境がこれからのスーパーコンピューターの主流になっていくとした。